Dubbele inhoud is de meest voorkomende optimalisatiefout op een pagina. Dubbele inhoud

Dubbele inhoud is een van de grootste problemen van een lage ranking van websites in zoekmachines. Dit probleem wordt veroorzaakt door de aanwezigheid op de site van pagina's die geheel of gedeeltelijk identiek aan elkaar zijn. Voor zoekmachines vormt de aanwezigheid van ongewenste pagina's op een website uiteraard een ernstig probleem, omdat ze serverkracht moeten besteden om deze te verwerken. Het heeft geen zin dat zoekmachines fysieke middelen verspillen aan het indexeren van dergelijke nutteloze inhoud. Daarom bestrijden ze dergelijke sites door er een filter op toe te passen of door ze in de ranking te verlagen, wat leidt tot lage posities voor gepromote zoekopdrachten.

Duplicaten en SEO

De aanwezigheid van dubbele pagina's op de site leidt tot het volgende:

- Nuttig link-sap wordt verspild aan deze nutteloze pagina's.

- Na de volgende update verplaatst de dubbele pagina de doelpagina en verliest deze zijn positie.

- Dubbele inhoud vermindert het unieke karakter van alle pagina's waarop deze is geplaatst.

- Omdat de zoekmachine dergelijke pagina's bestrijdt door ze uit de zoekresultaten te verwijderen, kan deze ook de pagina uitsluiten die wordt gepromoot.

Classificatie van duplicaten en oplossingen om ze te elimineren

Duplicaten kunnen compleet of gedeeltelijk zijn. Volledige duplicaten zijn wanneer de pagina's volledig identiek zijn. Er is dus sprake van gedeeltelijke duplicaten wanneer de pagina's niet volledig overeenkomen. Volledige duplicaten worden geëlimineerd met behulp van robots.txt en het instellen van 301-omleidingen. Gedeeltelijke duplicaten worden geëlimineerd door de nodige wijzigingen aan te brengen op de site.

Hier is een lijst met checklists die u moet doorlopen om het probleem van duplicaten te identificeren en op te lossen:

- Zoek naar duplicaten van de hoofdpagina van de site. Er kunnen bijvoorbeeld de volgende startpagina-opties zijn: http://www.domen.com/, http://www.domen.com/index.php, http://www.domen.com, http:/ /domen com/, https://www.domen.com/, http://www.domen.com/index.html. Zoals u kunt zien, zijn er veel opties, maar de optimale optie is http://www.domen.com/. Om andere kopieën van de hoofdpagina te elimineren, wordt een 301-omleiding en afsluiting in robots.txt gebruikt (in het geval van structuren zoals https://www.domen.com/.

- Controle van de fundamentele (gouden regel van SEO) - elke pagina mag slechts op één adres toegankelijk zijn. De adressen kunnen als volgt niet variëren: http://www.domen.com/stranica1/stranica2/ en http://www.domen.com/stranica2/stranica1/.

- Controleren op de aanwezigheid van variabelen in de URL. Ze mogen niet in het paginaadres voorkomen. Het genereren van URL's zoals: http://www.domen.ru/index.php?dir=4567&id=515 is bijvoorbeeld een fout. De juiste URL zou zijn: http://www.domen.ru/dir/4567/id/515.

- Controleren op de aanwezigheid van sessie-ID's in URL's. URL's zoals http://www.domen.ru/dir/4567/id/515.php?PHPSESSID=3451 zijn bijvoorbeeld onaanvaardbaar. Dergelijke URL's bevatten een oneindig aantal exemplaren van elke pagina. Daarom is het noodzakelijk om alle sessie-ID's in robots.txt te sluiten.

Dubbele inhoud verslechtert de site-indexering

“Verschillende wegen leiden naar verschillende plaatsen, en slechts één daarvan is de juiste.”

Hallo vrienden! Ik ben al lang van plan dit onderwerp op de pagina's van mijn website te bespreken, daarom besloot ik, nadat ik behoorlijk wat materiaal had bestudeerd over duplicatie van inhoud en de oorzaken, gevolgen en manieren om dit negatieve fenomeen te elimineren, mijn gedachten hierover te presenteren probleem met mijn bescheiden bron.

Wees geduldig en bestudeer zorgvuldig alle aanbevelingen in het artikel en controleer vervolgens de status van uw bronnen. Als u een uitstekende ranking van uw websitepagina's in zoekmachines wilt zien, volg deze dan strikt.

Zonder de pretentie te hebben alle mogelijke manieren te bieden om de oorzaken van dubbele inhoud weg te nemen, zal ik echter voorstellen de belangrijkste punten van deze kwestie te bestuderen.

Als een gewone gebruiker (en soms de webmaster zelf) dubbele inhoud op een site niet opmerkt, zullen zoekmachines dit onmiddellijk detecteren. Hun reactie zal duidelijk zijn: inhoud van deze pagina's zal niet langer uniek zijn. En dit is al niet goed, omdat het hun ranking negatief zal beïnvloeden.

Bovendien dubbel werk vervaagt het gewicht van de link, naar een specifiek bericht dat u, door te optimaliseren, naar de TOP probeerde te promoten, zoals een landingspagina. Duplicaten zullen eenvoudigweg alle pogingen om het te optimaliseren verpesten, en het effect van onderlinge koppelingen zal minimaal zijn.

Wat zijn dubbele inhoud?

1. Inhoud die door iemand of u persoonlijk is gekopieerd en op bronnen van derden is geplaatst.

Op internet kun je veel artikelen lezen over hoe om te gaan met gestolen content, een van de opties is mijn artikel. Of het kan worden uitgeroeid is een retorische vraag en vandaag de dag zijn er naar mijn mening geen fundamentele oplossingen voor dit probleem op internet. Er zijn slechts een paar meer of minder effectieve technieken.

2. Inhoud is een duplicaat dat de webmaster met zijn eigen handen maakt.

Een compleet (of onvolledig) duplicaat bij het verspreiden van informatie (of, zoals ze ook worden genoemd, aankondigingen) op speciale sites en forums. Als u een kopie van uw invoer op internet wilt hebben, dupliceer deze dan op een goede bron - het resultaat zal bijna altijd onmiddellijk zijn. Een duplicaat is rechtstreeks op de sitepagina's mogelijk. Heeft u ooit twee identieke pagina's op uw website gezien terwijl u er maar één had gemaakt? Waarom gebeurt dit? Redenen zijn onder meer het bewerken van inzendingen of het opslaan van onvoltooide in concepten, en vervolgens per ongeluk een duplicaat maken. De webmaster leeft, zonder het zelf te merken en zonder vervolgens al zijn inzendingen door te nemen, om geen duplicaat te ontdekken, nog lang en gelukkig, zonder te vermoeden dat hij een “tweeling”, een “drieling”, enz. heeft.

3. Duplicatie om technische redenen - het voorkomen van duplicaten waarvoor het CMS de schuld heeft.

Deze fouten verschijnen omdat CMS-ontwikkelaars niet denken als browsers of zoekspiders, maar denken zoals ontwikkelaars van website-engines zouden moeten denken; Veel mensen maken zich hier schuldig aan - Joomla bijvoorbeeld.

Laat me het een beetje uitleggen. Stel dat u een artikel met een trefwoord heeft "dubbele inhoud". Het moet zich op een pagina bevinden met het volgende adres: http://domein.ru/duplicatie van inhoud/, maar dezelfde inhoud kan bijvoorbeeld als volgt worden weergegeven: http://domain.ru/article-category/duplicatie van inhoud/. En als we ook rekening houden met andere duplicatie, pagina's bijvoorbeeld: http://domein.ru/duplicatie van inhoud/?source=rss. Al deze URL's zijn voor iedereen verschillende adressen, maar hetzelfde voor de gebruiker (lezer). Door deze verschillen kan de webmaster nagaan waar de gebruiker vandaan komt, maar ze kunnen ook schade veroorzaken als de noodzakelijke indexeringsinstellingen niet worden opgegeven.

Het is bekend dat websites werken dankzij een bestaand databasesysteem. Er is slechts één versie van een bepaald artikel (ID) in de database, maar de sitescripts staan dit toe toon dit artikel uit de database op verschillende pagina's (URL). Maar zoekmachines hebben een document (URL) nodig - alleen is het een unieke identificatie en niets anders!

4. Vage opnames.

Een speciaal soort duplicatie die vooral voorkomt in online winkels, waar pagina's met productkaarten slechts in een paar zinnen met een beschrijving verschillen, en de rest van de inhoud, bestaande uit end-to-end blokken en andere elementen, hetzelfde is . Het is moeilijk om de webmaster de schuld te geven, hoewel er enkele opties zijn om deze te elimineren.

We hebben dus de oorzaken en gevolgen van dubbele inhoud aangepakt. Laten we nu verder gaan met het oplossen van problemen. Laten we eerst eens kijken

Hoe dubbele pagina's detecteren?

1. Handmatige methode.

1) Als uw inhoud niet te groot is, bladert u gewoon door de pagina in het beheerdersdashboard "Alle inzendingen» en, als er duplicaten worden gevonden, verwijder dan de onnodige.

2) Om de aanwezigheid van duplicaten te achterhalen, kunt u de diensten van de zoekmachines “Yandex Webmaster” of Google Webmaster Tools gebruiken.

Open bijvoorbeeld in Webmaster Tools de pagina “Webmasterhulpprogramma’s” - “Optimalisatie” - “HTML-optimalisatie”: Als er fouten en duplicaten zijn, laat de wizard u alles zien. Zoek het uit met klikken en elimineer tegelijkertijd fouten en duplicaten.

3) Gebruik de systeemzoekvensters rechtstreeks (methode bij benadering). Voer voor elk van hen een invoer van het formulier in site: domein.ru en vergelijk hun resultaten. Als ze niet erg verschillend zijn, is je duplicatie niet zo erg.

4) Er is één effectieve manier om duplicaten te vinden: door tekstfragmenten zoeken. Dit gebeurt eenvoudig: voer in het zoekvenster van elk systeem een tekstfragment van uw bericht (artikel) van 10-20 woorden in (bij voorkeur vanuit het midden) en analyseer het resultaat. De aanwezigheid van twee of meer pagina's in de zoekresultaten betekent dat er duplicaten zijn voor dit opus. Zo niet, dan kunt u zich een beetje verheugen :).

Het is moeilijk als de site veel pagina’s heeft verzameld. De bovenstaande controle kan een ondraaglijk karwei worden. Als u de tijdskosten wilt minimaliseren, gebruik dan het programma Xenu's Link-speurder.

Wie heeft een link nodig om het bestand van dit programma te downloaden, schrijf in de reacties, ik zal het naar je e-mail sturen.Om de site te controleren, moet u een nieuw project openen door "Controleer URL" te selecteren in het menu "Bestand", voer het adres in en klik op "OK". Hierna begint het programma met het verwerken van alle site-URL's. Nadat u de controle heeft voltooid, moet u de ontvangen gegevens naar een handige editor exporteren en naar duplicaten gaan zoeken.

We hebben dus ontdekt welke (belangrijkste) redenen leiden tot dubbele inhoud. Laten we nu bepalen hoe we het kunnen elimineren.

Manieren om dubbele inhoud te elimineren

Canonieke URL's - een conceptuele oplossing voor het probleem

Als je niet de optie () hebt om duplicaten te verwijderen, kan het probleem worden opgelost met behulp van de tag Canonica l (gebruikt voor vage kopieën). De canonieke tag is ook geschikt voor versies pagina's om af te drukken en in andere soortgelijke gevallen. Het wordt heel eenvoudig toegepast: het attribuut rel=”canonical” wordt gespecificeerd voor alle kopieën, maar niet voor de hoofdpagina, die het meest relevant is. De code zou er ongeveer zo uit moeten zien: link rel=”canonical” href=”http://domain.ru/page-copy”/, en moet binnen de head-tag staan.

Voor gebruikers met de WordPress-engine is er een geweldige mogelijkheid om dit allemaal automatisch te doen door de alles-in-één SEO-pakketplug-in of iets dergelijks te installeren. In de instellingen wordt deze bewerking ingesteld met de volgende labels:

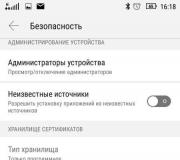

Disallow-functies instellen in het robots.txt-bestand van uw site

Hoewel het instellen van het verbieden van pagina's voor indexering niet altijd een effectieve manier is om duplicaten te voorkomen, aangezien zoekmachines er soms in slagen deze te omzeilen, zal een goed geconfigureerde robot.txt de taak om deze te voorkomen aanzienlijk vergemakkelijken.

METwwwof zonderwww

Hoe zien uw websitepagina's eruit - met alleen http of http.www? Onzekerheid zal dubbel werk creëren. Bepaal onmiddellijk na het maken van de site welk hypertext-transportprotocol u gaat gebruiken. Om dit te doen, voert u uw keuze in de webmasterpanelen van Yandex en Google in (in Google kan dit voor beide versies worden gedaan, maar u moet de rechten op beide adressen bevestigen). Je kunt het standaard laten staan of ‘zoekrobotkeuze’, maar het is beter om het duidelijk te definiëren.

Een omleiding instellen

De 301-omleiding is ideaal voor het samenvoegen van kopiepagina's waarvan de URL's verschillen in de aan- en afwezigheid van www. Zoals je al hebt begrepen (zie screenshot hierboven), wordt het opzetten van een redirect op WordPress ook vereenvoudigd met behulp van de plug-in. Als u en de zoekrobot uw keuze hebben “beslist” – met of zonder www of zonder www, zal er in wezen een hoofddomein zijn, is het instellen van een omleiding voor alle pagina’s niet nodig. Het onderwerp van het opzetten van een omleiding en de haalbaarheid ervan is echter het onderwerp van een apart artikel.

Resultaten en conclusies

- sta geen duplicatie van pagina's (inhoud) in uw bronnen toe, aangezien duplicaten leiden tot een ernstige afname van de relevantie van pagina's, waardoor het moeilijk wordt om ze op de voorgrond van de zoekresultaten (TOP) te plaatsen;

- De meeste problemen met dubbele inhoud hebben een oplossing: gebruik hiervoor alle mogelijke middelen;

- Houd voortdurend toezicht op het proces van het indexeren van uw inhoud en het voorkomen van duplicaten ervan

Dat is het, beste lezer. Als je iets hebt toe te voegen of te corrigeren, stel dan een vraag - waag je kans!

Niet helemaal on-topic, maar over een tweeling.

(28 keer bezocht, 1 bezoek vandaag)

Inhoud (Engels: inhoud) - informatie, namelijk tekst, afbeeldingen, video's, bestanden die zich op de site bevinden.Het zou moeten zijn:

- Het meest complete en begrijpelijke antwoord geven, het probleem van een persoon oplossen: of het nu gaat om opvrolijken, een einde maken aan een moeilijk dilemma of een kwaliteitsproduct kopen.

- Zonder gebruik te maken van verborgen fragmenten zoals:

- de tekst heeft dezelfde kleur als de achtergrond,

- de tekst is verborgen door de afbeelding die zich erachter bevindt,

- lettergrootte is ingesteld op 0.

- De belangrijkste ideeën worden in kleur of vetgedrukt gemarkeerd, zodat de gebruiker zich daarop kan concentreren. Vergeet niet dat webpagina's niet worden gelezen, maar geskimmt.

- door de structuur van het artikel wordt geïmplementeerd,

- zinnen worden gecombineerd tot alinea's met een witregel ertussen,

- gebruikte lijsten, citaten, tabellen,

- Er werd gebruik gemaakt van foto's, infographics, video's en audio-opnamen. Beelden spelen een grote rol. Eén lezer van deze blog vroeg dus om de karakters in de schermafbeelding die de Blogger-editor liet zien, te vertalen.

Duplicatie van inhoud kan niet alleen worden waargenomen wanneer gegevens op verschillende sites worden geplaatst, maar ook wanneer informatie wordt herhaald op twee of meer dan één webproject. Hier is een experiment op devvver.ru over het negatieve van interne duplicaten en hoe concurrenten hiervan kunnen profiteren.

Laten we eens kijken welke hulpmiddelen we hebben in de strijd tegen deze ziekte.

Links naar pagina

De enige De 100% manier om te voorkomen dat een pagina wordt geïndexeerd, is door er geen links naar te plaatsen en deze niet toe te voegen aan Yandex-add-ons. Googlen enz.

Robots.txt-bestand

Een robots.txt-tekstbestand (zoals ) is een uitstekend hulpmiddel voor het beheren van indexering. Help Yandex, Google. Maar als Google een link naar een gesloten URL in robots.txt vindt, wordt deze aan de resultaten toegevoegd.

Daarom moet u hier naar binnen gaan alleen die webdocumenten die op geen enkele andere manier bereikbaar zijn, Bijvoorbeeld, . En natuurlijk sitemap voor een betere en snellere indexering van populaire pagina's.

HTTP-header

De URL wordt niet geïndexeerd als deze 404 of 301 weergeeft. En voor Google, zelfs als de regel aanwezig is

X-Robots-Tag: noindex

Meta-robottags

Dit belangrijkste hulpmiddel, omdat het voor zowel Yandex als Google hetzelfde werkt. Op de pagina waarvan de toegang tot de inhoud verboden zou moeten zijn, wordt het volgende aangegeven:

Het rel="canonieke" attribuut

Vereist het rel="canonical" attribuut suggereert het voorkeurskenmerk uit verschillende webdocumenten met zeer vergelijkbare inhoud, bijvoorbeeld http://site/2010/07/kontent..html?showComment. De zoekmachine zal de tweede negeren omdat deze de volgende regel zal gehoorzamen:

Yandex.Webmaster

media = "afdrukken"

Het is niet nodig om een aparte printbare versie te maken. Stijlen kunnen worden aangepast met .

Duplicaten verwijderen die per ongeluk in de index staan

Ondanks de genomen maatregelen kunnen zoekrobots de ongewenste pagina indexeren. Door een verzoek in te dienen

Bekijk alle zoekresultaten, vooral de zoekresultaten met weggelaten Google-resultaten. Idealiter zou deze inscriptie niet moeten zijn:

Weggelaten resultaten moeten handmatig worden verwijderd. Voor Yandex gebruiken we het formulier voor het verwijderen van pagina's, en voor Google moet je naar "Webmaster Tools" - "Optimalisatie" - "URL's verwijderen" - "Een nieuw verwijderingsverzoek maken" gaan.

Dubbele inhoud, of eenvoudigweg duplicaten, zijn pagina's op uw site die volledig (duidelijke duplicaten) of gedeeltelijk (vage duplicaten) hetzelfde zijn, maar elk een andere URL hebben. Eén pagina kan een of meerdere duplicaten bevatten.

Hoe verschijnt dubbele inhoud op een website?

Voor zowel duidelijke als onduidelijke opnames zijn er verschillende redenen waarom ze voorkomen. Duidelijke duplicaten kunnen om de volgende redenen voorkomen:

- Ze verschijnen vanwege het CMS van de site. Als u bijvoorbeeld antwoordtocom in WordPress gebruikt, worden bij het toevoegen van nieuwe opmerkingen automatisch nieuwe pagina's gemaakt die alleen in URL verschillen.

- Als gevolg van webmasterfouten.

- Vanwege veranderingen in de structuur van de site. Bijvoorbeeld bij het implementeren van een bijgewerkte sjabloon met nieuwe URL's.

- Gemaakt door de site-eigenaar voor bepaalde functies. Bijvoorbeeld pagina's met afdrukbare versies van de tekst.

Er kunnen om de volgende redenen onduidelijke duplicaten op uw site verschijnen:

Waarom is dubbele inhoud schadelijk voor een website?

- Heeft een negatieve invloed op de promotie in de zoekresultaten. Zoekrobots hebben een negatieve houding ten opzichte van dubbele inhoud en kunnen hun positie in de zoekresultaten verlagen vanwege het gebrek aan uniekheid, en dus bruikbaarheid voor de klant. Het heeft geen zin om hetzelfde op verschillende pagina's van de site te lezen.

- Kan echt relevante pagina's vervangen. De robot kan ervoor kiezen een dubbele pagina terug te sturen als hij de inhoud ervan relevanter acht voor het verzoek. Tegelijkertijd heeft het duplicaat in de regel lagere indicatoren voor gedragsfactoren en/of linkmassa dan de pagina die u doelbewust promoot. Dit betekent dat de dubbelganger op slechtere posities wordt getoond.

- Leidt tot verlies van natuurlijke verbindingen. Wanneer de gebruiker een link maakt niet naar het prototype, maar naar een duplicaat.

- Bevordert een onjuiste verdeling van het interne linkgewicht. Duplicaten trekken een deel van het gewicht van de gepromote pagina's weg, wat ook de promotie in zoekmachines belemmert.

Hoe kunt u controleren of u duplicaten heeft of niet?

Er zijn verschillende manieren om erachter te komen of sitepagina's duplicaten hebben of niet.

Heeft u duplicaten gevonden? We lezen hoe je ze kunt neutraliseren:

- 301e omleiding Deze methode wordt als de meest betrouwbare beschouwd bij het verwijderen van onnodige duplicaten op uw website. De essentie van de methode is om de zoekrobot van de dubbele pagina naar de hoofdpagina om te leiden. De robot slaat dus de dubbel over en werkt alleen met de vereiste pagina van de site. Na verloop van tijd, na het instellen van de 301e omleiding, blijven dubbele pagina’s aan elkaar plakken en vallen ze uit de index.

- Label . Hier geven we aan de zoekmachine aan welke pagina onze hoofdpagina is, bedoeld voor indexering. Om dit te doen, moet u bij elke opname een speciale code voor de zoekrobot invoeren , die het adres van de hoofdpagina zal bevatten. Om dergelijk werk niet handmatig te hoeven doen, zijn er speciale plug-ins.

- Niet toestaan in robots.txt. Het robots.txt-bestand is een soort instructie voor de zoekrobot, die aangeeft welke pagina's geïndexeerd moeten worden en welke niet. Om indexering te verbieden en duplicaten tegen te gaan, wordt de Disallow-richtlijn gebruikt. Hier is het, net als bij het instellen van een 301-omleiding, belangrijk om het verbod correct in te stellen.

Hoe duplicaten uit de zoekmachine-index te verwijderen?

Wat Yandex betreft, het verwijdert onafhankelijk duplicaten uit de index als het robots.txt-bestand correct is geconfigureerd. Maar voor Google moet u regels instellen op het tabblad “URL-opties” via Google Webmaster.

Als u problemen ondervindt bij het controleren en verwijderen van dubbele inhoud, kunt u altijd contact opnemen met onze specialisten. We zullen alle verdachte elementen vinden, een 301-omleiding instellen, robots.txt, rel="canonical", instellingen maken in Google. Over het algemeen zullen wij al het werk uitvoeren om ervoor te zorgen dat uw website effectief werkt.

“Ik heb het onderwerp dubbele pagina’s al besproken en vandaag zullen we er meer in detail over praten.

Wat is er gebeurd dubbele pagina's? Dit zijn pagina's met vergelijkbare of identieke tekst die beschikbaar zijn op verschillende URL's. Bijvoorbeeld veel voorkomende duplicaten van de hoofdpagina van de bron

Hieronder zullen we een aantal veelvoorkomende opties voor het dupliceren van inhoud bekijken, maar laten we het nu hebben over de gevolgen daarvan soortgelijke pagina's voor websitepromotie.

Zoekmachines hebben lang geleerd het unieke karakter van tekst te bepalen aan de hand van een reeks tekens, dat wil zeggen aan de hand van identiek samengestelde zinnen, waaruit de reeks letters en spaties is afgeleid. Als de inhoud niet uniek is (gestolen), zal de robot dit gemakkelijk achterhalen, en als niet-unieke tekst vaak voorkomt, is de kans groot dat een dergelijke bron onder het AGS-filter valt.

Laten we ons het werk van een zoekrobot voorstellen. Als hij een website bezoekt, is het eerste waar hij naar kijkt het bestand. robots.txt en krijgt van hem instructies: wat moet geïndexeerd worden en wat is gesloten voor indexering. De volgende actie is het openen van het sitemap.xml-bestand, dat de robot een sitemap toont met alle toegestane routes. Lees het artikel - “Sitemap.xml-bestand voor Google- en Yandex-zoekmachines.” Nadat hij alle benodigde informatie heeft ontvangen, gaat de robot op pad om zijn gebruikelijke functies uit te voeren.

Nadat hij een bepaalde pagina heeft bezocht, 'absorbeert' hij de inhoud ervan en vergelijkt deze met de informatie die al beschikbaar is in zijn elektronische hersenen, verzameld uit het hele uitgestrekte internet. Omdat de zoekmachine heeft vastgesteld dat de tekst niet uniek is, zal hij deze pagina niet indexeren en een aantekening maken in zijn notitieboekje waarin hij de ‘overtredende’ URL’s registreert. Zoals je waarschijnlijk al geraden had, zal hij niet meer naar deze pagina terugkeren, om zijn kostbare tijd niet te verspillen.

Laten we zeggen dat de pagina zeer uniek is en dat de robot deze heeft geïndexeerd, maar dat na het volgen van de volgende URL van dezelfde bron de pagina op een pagina terechtkomt met geheel of gedeeltelijk vergelijkbare tekst. Wat zou een zoekmachine in zo’n situatie doen? Uiteraard zal hij een soortgelijke test ook niet indexeren, ook al staat het origineel op dezelfde site, maar op een andere URL. De robot zal waarschijnlijk ontevreden zijn over de verspilde tijd en zal zeker een aantekening maken in zijn notitieboekje. Nogmaals, als een dergelijk incident herhaaldelijk wordt herhaald, kan de bron uit de gratie raken bij de zoekmachine.

Conclusie nr. 1. Soortgelijke pagina's op verschillende URL's nemen de tijd in beslag die aan de robot is toegewezen voor het indexeren van de site. Het zal nog steeds geen dubbele pagina's indexeren, maar het zal een deel van de tijdslimiet besteden aan het leren kennen ervan en heeft mogelijk geen tijd om echt unieke inhoud te ontdekken.

Conclusie nr. 2. Dubbele inhoud heeft een negatief effect op de promotie van uw website in zoekmachines. Zoekmachines houden niet van niet-unieke teksten!

Conclusie nr. 3. U moet uw project zeker controleren op dubbele pagina's om de hierboven genoemde problemen te voorkomen.

Veel mensen geven helemaal niets om de ‘zuiverheid’ van hun inhoud. Uit nieuwsgierigheid heb ik verschillende sites bekeken en was enigszins verrast door de stand van zaken met dubbele pagina's. Op de blog van een vrouw vond ik helemaal geen robots.txt-bestand.

Het is noodzakelijk om dubbele inhoud serieus te bestrijden en te beginnen met het identificeren ervan.

Voorbeelden van veel voorkomende dubbele inhoud en manieren om het probleem op te lossen

Dupliceer de hoofdpagina. Voorbeeld:

- http://site.com

- http://site.com/index.php.

In dit geval wordt het probleem opgelost met behulp van een 301-omleiding - een "opdracht" voor de server via het .htaccess-bestand.

Nog een voorbeeld van een duplicaat van een startpagina:

- http://site.com

- http://www.site.com

Om dergelijke duplicatie te voorkomen, kunt u de hoofdspiegelserver van de site in het bestand registreren robots.txt in de richtlijn - "Gastheer" voor Yandex:

- Host: site.com

En profiteer ook 301 omleiding en wijs zoekmachines van Yandex en Google naar de hoofdspiegel van de site met behulp van webmastertools.

Een voorbeeld van een duplicaat van een startpagina waar ik bijna van versteld stond bij het zoeken naar een oplossing ziet er als volgt uit:

- http://site.com

- http://site.com/

Ik heb ergens gelezen dat een schuine streep aan het einde van een link naar de hoofdpagina een dubbele creëert en dat zoekmachines links met en zonder schuine streep waarnemen als verschillende URL's die naar een pagina met dezelfde tekst leiden. Wat mij zorgen baarde was niet de mogelijkheid van duplicatie zelf, maar het gewichtsverlies van de hoofdpagina in een dergelijke situatie.

Ik begon te graven. Op verzoek aan de server op de bovenstaande URL's ontving ik een responscode 200. Code 200 betekent: "Het gebruikersverzoek is succesvol verwerkt en het antwoord servers bevat de gevraagde gegevens." Hieruit volgt dat het nog steeds een dubbelganger is.

Ik heb zelfs geprobeerd een 301-redirect (redirection) uit te voeren, maar de commando's werkten niet en ik ontving nog steeds de gewenste 301-responscode. De oplossing voor het probleem was de afwezigheid van het probleem zelf. Dit is een woordspeling. Het blijkt dat moderne browsers zelf het teken “/” aan het einde van de regel invoegen, waardoor het onzichtbaar wordt, wat het dubbele automatisch onmogelijk maakt. Zoals dit!

Nog een voorbeeld van een duplicaat van de hoofdpagina:

- http://site.com

- https://site.com

Er zijn momenten waarop, als gevolg van een fout van de webmaster, een fout in de zoekmachine, of onder andere omstandigheden, een link onder het beveiligde https://-protocol in de index terechtkomt. Wat moet u in dergelijke gevallen doen en hoe kunt u dit in de toekomst voorkomen? Uiteraard moet u links met het https://-protocol uit de zoekopdracht verwijderen, maar u zult dit handmatig moeten doen met behulp van webmastertools:

In de Yandex-zoekmachine, webmaster — mijn sites — verwijder URL:

Belangrijk ! Richtlijnen geschreven in het robots.txt-bestand verbieden zoekrobots om tekst te scannen, waardoor de site tegen duplicaten wordt beschermd, maar dezelfde richtlijnen verbieden niet het indexeren van pagina-URL's.

Lees meer in de artikelen:

Er is nog een redelijk effectieve manier om “klonen” te identificeren met behulp van de zoekmachines zelf. In Yandex moet u in het zoekveld invoeren: link.site.com “Testfragment”. Voorbeeld:

Yandex heeft 2 overeenkomsten gevonden omdat ik de categorie niet heb geblokkeerd voor indexering en daarom is er een overeenkomst met de aankondiging op de hoofdpagina. Maar als voor een culinaire blog de deelname van categorieën aan de zoekopdracht gerechtvaardigd is, dan is er voor andere onderwerpen, zoals SEO, geen behoefte aan en is het beter om de categorieën te sluiten voor indexering.

U kunt dit als volgt controleren met Google Zoeken: site:site.com “Tekstfragment.” Voorbeeld:

Programma's en onlinediensten voor het zoeken naar interne en externe duplicaten van inhoud met behulp van tekstfragmenten

In dit artikel zal ik geen gedetailleerd overzicht geven van populaire programma's en diensten; ik zal me alleen concentreren op de programma's en diensten die ik zelf voortdurend gebruik.

Om naar interne en externe duplicaten te zoeken, raad ik u aan de online service www.miratools.ru te gebruiken. Naast tekstcontrole bevat de dienst verschillende interessante functies.

Programma voor het vinden van duplicaten - Advego Plagiatus. Een zeer populair programma, ik gebruik het persoonlijk altijd. De functionaliteit van het programma is eenvoudig; controleer de tekst, kopieer en plak deze in het programmavenster en klik op start.

Na controle wordt een rapport gepresenteerd over de uniciteit van de tekst die wordt gecontroleerd, in procenten, met links naar bronnen van overeenkomsten:

Ook worden specifieke tekstfragmenten waarvoor het programma overeenkomsten heeft gevonden, gemarkeerd met een gele achtergrond:

Zeer goed programma, gebruik het en abonneer je op blogupdates.

Tot snel!

Eerlijk, Kirillov Vitaly